OWL最新提交的结果在智能体测试基准GAIA的验证集上排名平均分第3,在开源项目中排第1。

虽然Level 2和Level 3分数还有差距,不过CAMEL-AI团队的李国豪在交流群中表示,有信心刷爆。

今日的GitHub热榜上,大多是Agent相关的项目和工具库,老牌Agent项目MetaGPT与AutoGPT双双被顶到前排。

Camel-AI、牛宝体育平台OpenManus所使用的代码库browser-use也现身,此外金融、编程等领域的垂直智能体也备受关注。

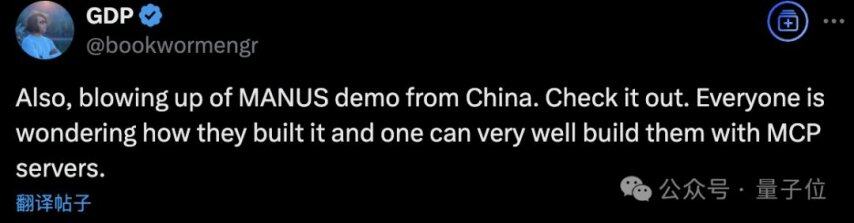

与此同时,有人注意到Claude团队推出的模型上下文协议MCP不是已经有小半年了么,为什么突然每个人都在讨论它?

原来是每个人都想知道如何造一个Manus,而MCP是一种有效的实现途径呀。

除了给海外大V单独发之外,Manus联创季逸超还与抱抱脸CEO取得联系,公开分享100个码,见者有份,先到先得。牛宝体育平台

两人的交流中季逸超谈到Agent能力可能更多的是对齐问题而不是基础能力问题,基础模型被训练为“无论任务有多复杂,都一次性回答所有问题”,而“只需对代理轨迹进行一点后期训练,就可以立即产生显著的变化”。

海外用户得到码之后的剧情和这边差不多,有不少试用之后被惊艳到的,变成“自来水”的。

并且海外用户的付费意愿确实要强一些,毕竟比起OpenAI两万美元一个月的博士级智能体总是要便宜许多。

很多人拿到Manus做的第一件事,都是让他收集自己的资料,编写并部署个人主页。

其中Rowan Cheung表示Manus收集到关于他的个人信息100%准确且是最新的。

他分享了体验中的一个细节:虽然Manus可以自己完成所有任务,但如果在执行过程中给出意见,它也可以灵活地改变计划并执行,就好像真的再给人下达指令一样。

也有人把它当做Deep Research类工具,寻找租房信息只花了不到10分钟时间。

作为Manus出圈的副作用之一,GAIA基准测试正在成为智能体类产品必争之地。

GAIA测试由450+具有明确答案的复杂问题组成,分为三个难度级别,考验智能体系统的工具使用能力以及自主性。

Level 1:通常解题步骤不超过5步,且不需要工具,或最多使用一种工具。如简单的信息检索和处理,任何优秀的语言模型都可以完成。

Level 2:需要在5-10步之间完成,并且需要组合使用不同工具。如“根据附件 Excel 文件计算当地快餐连锁店食品(不含饮料)的总销售额”。

Level 3:面向近乎完美的通用AI助手,要求AI能够执行任意长度的复杂动作序列,使用多种工具,并具备广泛的世界知识和信息获取能力。

如“在2006年1月21日NASA的每日天文图片中有两名宇航员,截至2023年8月,找出较小宇航员所在NASA宇航员小组中在太空停留时间最短的宇航员及其停留时间”,解答这类问题需要综合网络搜索、牛宝体育平台信息筛选、知识推理等多种能力。

人类在Level 2、和Level 3上的成功率分别是92%和87.3%,测试推出时最先进的语言模型GPT-4得分为9.7%和0。

此外GAIA排行榜分为测试集(Test)和验证集(Validation)两项,其中验证集是公开数据,测试集为私有数据,测试集的含金量更高一些。

ImageNet数据集与竞赛开启了深度学习浪潮之后,每个时代都有自己的当红榜单指引着最前沿技术的发展。

点击查看更多怀旧游戏视频